Here is the more detail I think.

First you can download from github http://sparkmonitor.github.io/varOne/varOne-0.1.0.tgz

Or on your Spark Server with "wget"

command

在實際開始安裝之前,請先修改$SPARK_HOME/conf的 metrics.propertis

如無此檔案,請先執行

加入

*.sink.csv.class=org.apache.spark.metrics.sink.CsvSink

*.sink.csv.period=1

*.sink.csv.unit=seconds

*.sink.csv.directory=/home/hadoop/CSV_SINK

driver.source.jvm.class=org.apache.spark.metrics.source.JvmSource

executor.source.jvm.class=org.apache.spark.metrics.source.JvmSource

#注意 csv.directory路徑請自行更改至您對應的路徑

接著修改 $SPARK_HOME/conf下的 spark-defaults.conf

如無此檔案請先執行

加入

spark.eventLog.enabled true

spark.eventLog.dir hdfs://hadoop-master:8020/Peter/eventLog

#注意 eventLog.dir 目前版本設定存放 hdfs,請修改及對應您的hdfs 目錄位置

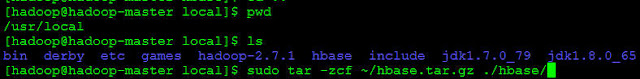

解壓縮檔案(建立安裝在

namenode上,這樣遠端呼叫datanode上的 varOne不需要再輸入密碼,因為hadoop cluster環境上已設定過 ssh)

修改 $VARONE_HOME/conf下3個檔案

varOne-env.sh,varOne-site.xml,varonedaemond

若無前兩個檔案,請自行複製一份並修改檔名

主要修改2個檔案

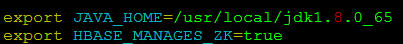

1.varOne-env.sh

2.varonedaemond

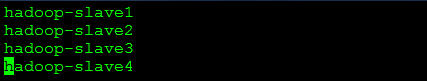

把你的Cluster環境中的所有hostname加入,注意一個hostname一行

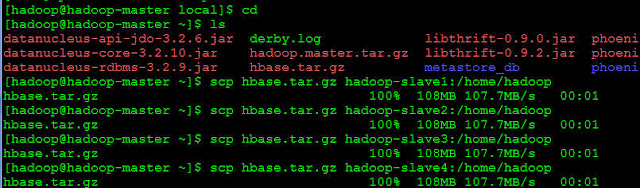

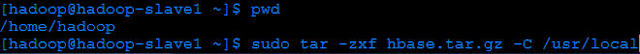

上述全部修改完畢後,請將varOne目錄複製一份至每個datanode上

我的習慣是先壓縮再傳送

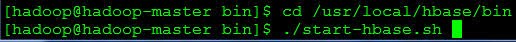

開始啟動 varOned 嘍!

注意啟動前,事實上Spark也必須複製一份至各個node(請重複SCP動作)

因為varOne.sh 需要去讀取$SPARK_HOME/conf的metrics.properties

啟動 varOne.sh for WebUI

開啟 WebUI default會在 8080 port

hadoop-master:8080/varOne-web/index.html